本日はMMDの学習枠です。

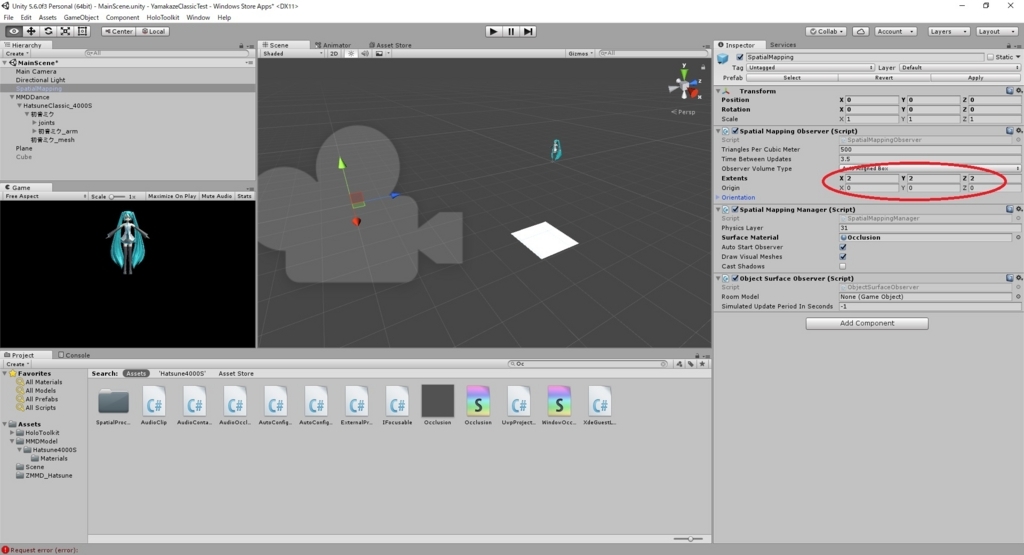

私事ですが、今週の金曜日、会社の勉強会でUnityのアニメーションについて簡単な講座を行う事となりました。

アニメーションについては一度記事を書いていますが、今週は改めて、Unityのアニメーション設定をまとめていきます。

bluebirdofoz.hatenablog.com

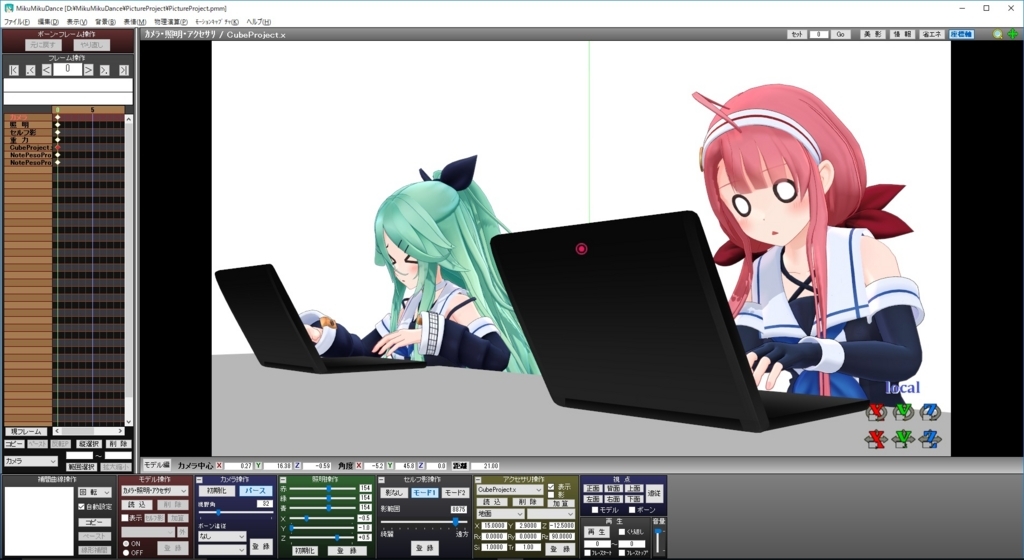

そして、それに当たり。折角ですから3Dモデルを自由に操作できるようになる楽しみが伝わるような講座にしたいと考えました。

資料の表紙に、3DモデルがPC操作を行っているCGを使うなんてどうでしょう。

早速、取り掛かりました。

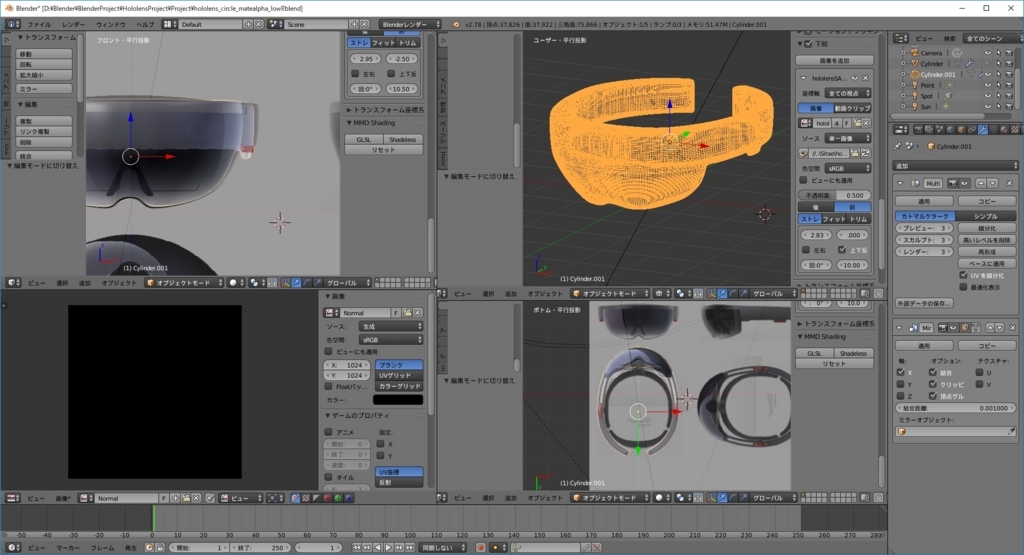

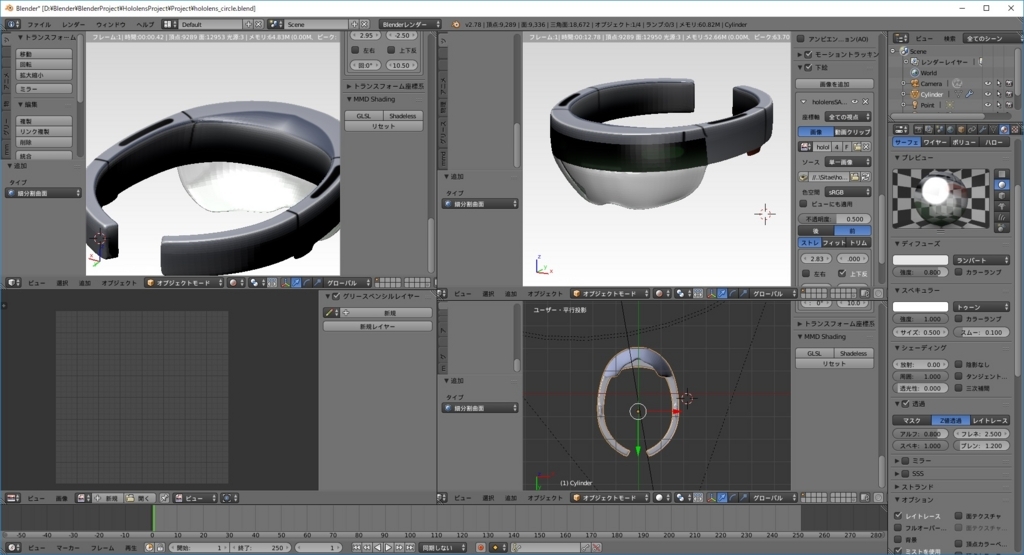

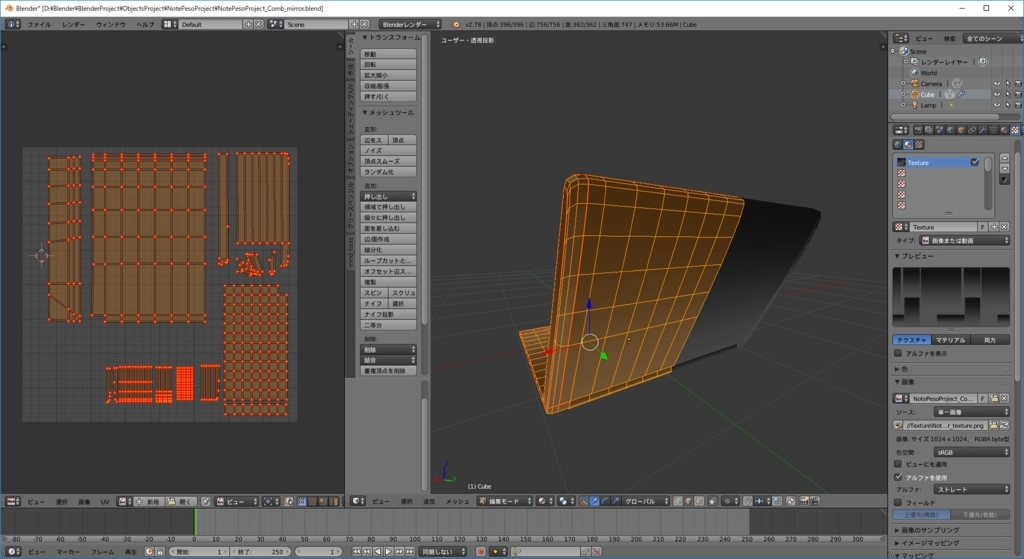

まずはCGで使うノートパソコンの3Dモデルをblenderで作成します。探せばフリーでありそうですが、3Dモデリングの復習も兼ねて自作です。

今回は背面しか見せないので、ディスプレイやキーボードは作り込んでいません。

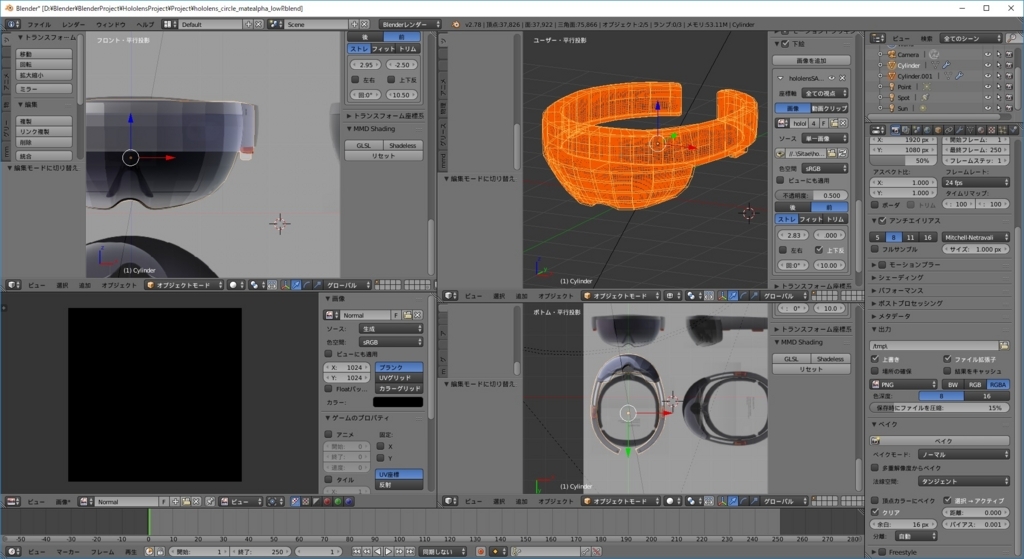

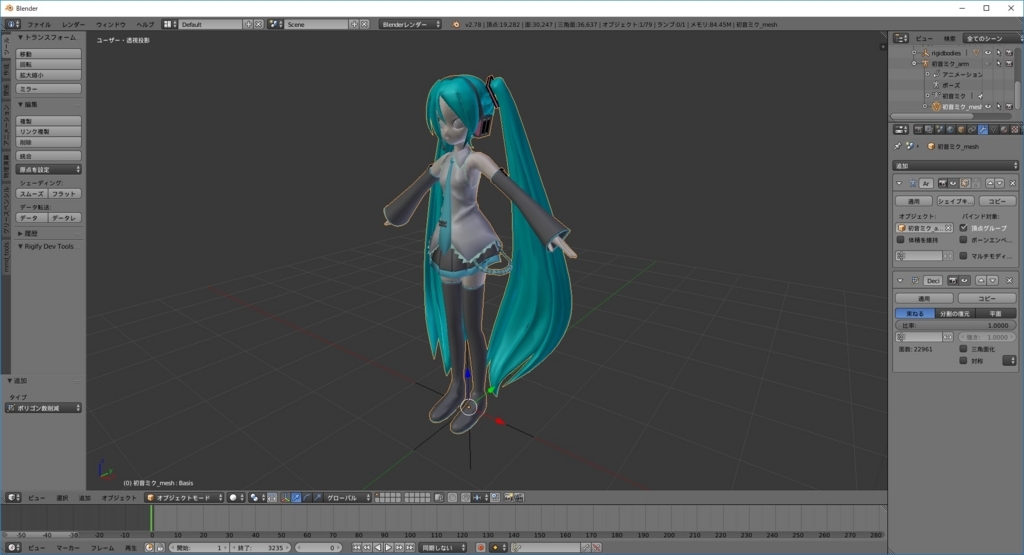

さて、このままblenderで画像を出力すれば良いんですが、折角の表紙CGです。高精細なMMDモデルも使いたくなりました。

しかし、MMDモデルはblender上では表情のモーフが使えないという問題に突き当たりました。

github.com

現状、blenderのアドオンであるmmd_toolsは頂点モーフにしか対応しておらず、MMDモデルの表情豊かなモーフが使えません。

これは勿体ない。

ですので、blenderで作成した3DモデルをMMD側に持っていき、MMD上で3Dモデルを撮影します。

これならばMMDモデルのモーフが利用可能です。

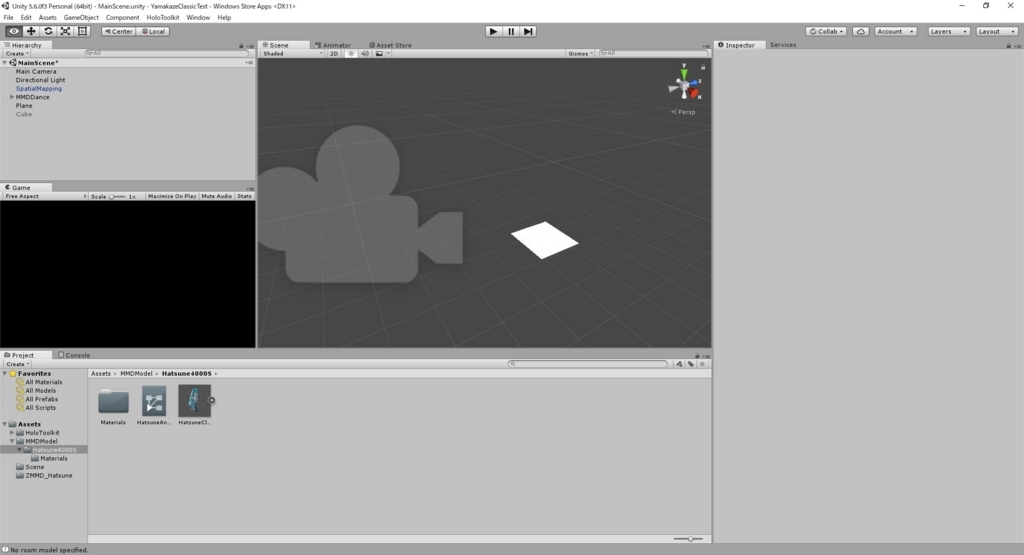

MMDではキャラクタ以外のオブジェクトを「アクセサリ」と表現しており、これらは x 形式のファイルで取り込めます。

作成したノートパソコンをblenderで x 形式のファイルでエクスポートします。

エクスポート形式にxファイルが存在しない場合は以下を参考にユーザ設定を変更してください。

・blender2.62でxファイルをエクスポートするのメモ

http://blog.livedoor.jp/hawamo21/archives/3997789.html

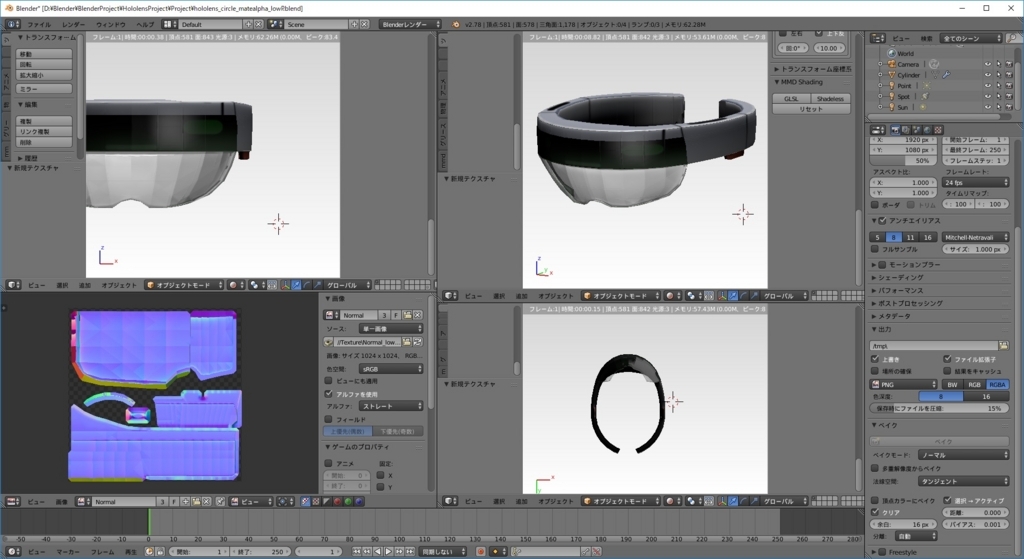

このとき、xファイルを読み込むと、3Dモデルにテクスチャファイルが反映されていない場合があります。

xファイルの中身をテキストファイルで確認して、指定の相対パスにテクスチャファイルが存在するか確認してみてください。

デフォルトだと、xファイルと同じディレクトリにテクスチャファイルが存在する必要があります。

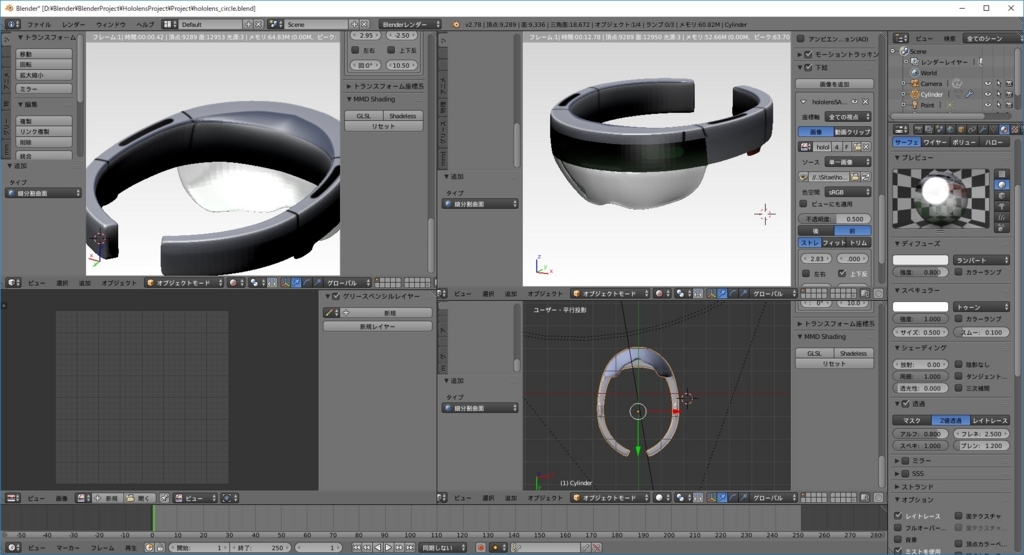

ノートパソコンを操作しているMMDキャラクタ達を配置します。MMD上なので様々な表情が簡単に付けられます。

表示->出力サイズ で静止画の出力サイズを設定して、ファイル->画像ファイルに出力 で画像を出力できます。

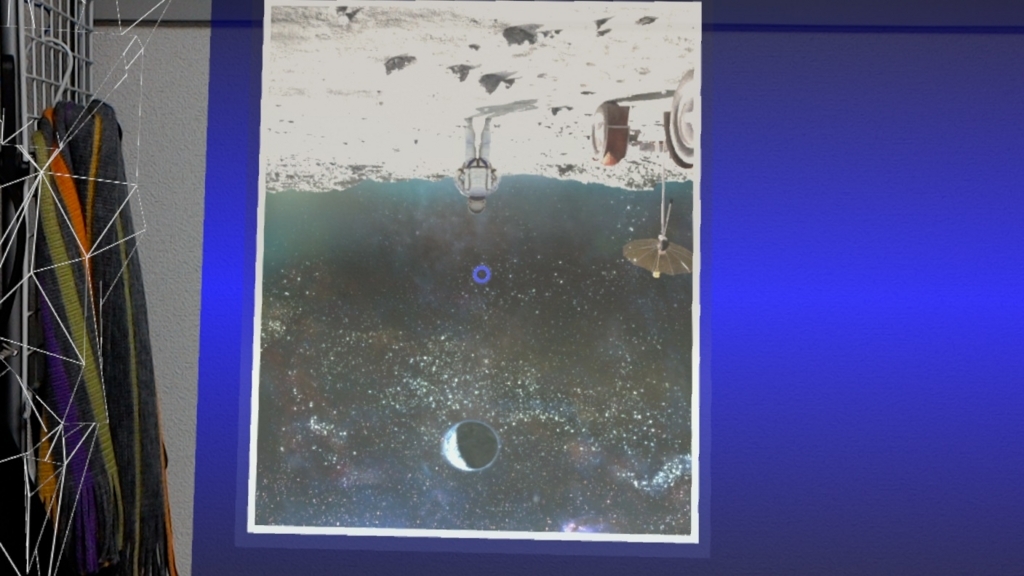

後は出力した画像をペイントでちょちょいとイジれば……。

3Dモデルを使った表紙CGの出来上がりです!

はい。見事に、表紙の作成のみで一日を費やしてしまいました。

明日からはちゃんとUnityのアニメーション設定のまとめに着手します。